激活函数(激活函数relu优点)

本篇文章给大家谈谈激活函数,以及激活函数relu优点对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

- 1、激活函数与损失函数

- 2、激活函数的作用是什么

- 3、激活函数思考

激活函数与损失函数

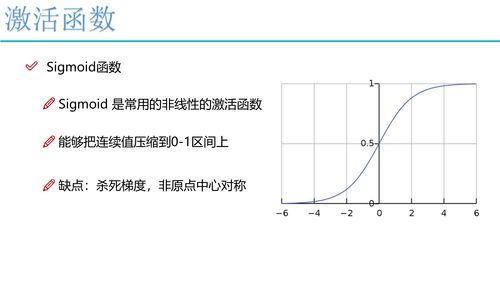

)如果使用sigmoid激活函数,则交叉熵损失函数一般肯定比均方差损失函数好;2)如果是DNN用于分类,则一般在输出层使用softmax激活函数和对数似然损失函数;3)ReLU激活函数对梯度消失问题有一定程度的解决,尤其是在CNN模型中。

激活函数是每一层神经网络之后用的非线性函数,因为神经网络本身是线型的,利用激活函数可以使之实现非线性。激活函数主要有四个: sigmoid, tanh, RELU, Leaky RELU. 还有一位博主将softmax 也加了进来。

当你执行二元分类任务时,可以选择该损失函数。如果你使用BCE(二元交叉熵)损失函数,则只需一个输出节点即可将数据分为两类。输出值应通过sigmoid激活函数,以便输出在(0-1)范围内。

激活函数的作用是什么

1、神经网络中激活函数的主要作用是提供网络的非线性建模能力,如不特别说明,激活函数一般而言是非线性函数。

2、这里首先引出结论: 激活函数是来向神经网络中引入非线性因素的,通过激活函数,神经网络就可以拟合各种曲线。 这里举一个例子来说明:假如我的任务是:将下面的这幅图中的三角形和圆形分开,也就是一个典型的二分类问题。

3、激活函数在神经网络当中的作用**是赋予神经网络更多的非线性因素。如果不用激活函数,网络的输出是输入的线性组合,这种情况与最原始的感知机相当,网络的逼近能力相当有限。

4、不同的激活函数是用来实现不同的信息处理能力,神经元的变换函数反映了神经元输出与其激活状态之间的关系。

5、激励函数的作用:通过激活函数会将数据压缩到一定的范围区间内,得到的数据的大小将决定该神经元是否处于活跃状态,即:是否被激活。这使得神经网络可以更好地解决较为复杂的问题。

激活函数思考

激活函数 : 神经网络神经元中,输入的 inputs 通过加权,求和后,还被作用了一个函数,这个函数就是激活函数 Activation Function。

线性整流函数(Rectified Linear Unit, ReLU),是一种深度神经网络中常用的激活函数,整个函数可以分为两部分,在小于0的部分,激活函数的输出为0;在大于0的部分,激活函数的输出为输入。

tanh(x) 型函数是在Sigmoid型函数基础上为解决均值问题提出的激活函数:tang(x) = 2S(2x)-1。

蓝海大脑图数据一体机研究人员表示: 非线性:即导数不是常数。这个条件是多层神经网络的基础,保证多层网络不退化成单层线性网络。这也是激活函数的意义所在。 几乎处处可微:可微性保证了在优化中梯度的可计算性。

激活函数的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于激活函数relu优点、激活函数的信息别忘了在本站进行查找喔。